Multiplos monitores no Windows? Use o UltraMon

Publicado; 14/01/2007 Arquivado em: Tecnologia 3 ComentáriosE já que é para fazer propaganda de softwares (na real eu não ganho nada por isso), vale sugerir um daqueles grandes-pequenos softwares que aumentam e melhoram bastante o uso do computador no dia a dia. Eu costumo plugar meu notebook num monitor adicional tanto em casa quanto no trabalho, e como usuário de Windows XP sofro com a falta de opções e até mesmo de previsibilidade do Windows no que diz respeito a gerenciar multiplos monitores.

O Ultramon supre estas e outras necessidades de quem usa multiplos monitores (notadamente designers e programadores). Confira aqui a lista de features.

PGP Whole Disk Encryption

Publicado; 14/01/2007 Arquivado em: Segurança 5 ComentáriosSe você já foi roubado conhece a sensação de absoluta impotência diante da violência (especialmente em caso de assalto). Depois do ocorrido, intercalam-se sentimentos de alívio (por você estar bem) e de raiva. Mas o alívio pode ser momentâneo, no caso de o objeto de furto ter sido o seu notebook, algo relativamente comum (infelizmente) hoje em dia.

Em meu notebook, por exemplo, eu carrego fotos da família, documentos importantes, emails de trabalho e pessoais, contratos incluindo os de aluguel, de compra (casa, carro), etc e uma infinidade de coisas absolutamente sensíveis que poderiam ser utilizadas para me identificar com detalhes, incluindo a possibilidade de usar meus dados para praticar golpes e afins. No meu notebook estão inclusos até mesmo os dados de rotina, horários e afins, já que costumo trocar e-mails e IMs com a minha esposa ao longo do dia. Essa montanha de dados vale ouro (muito mais que o próprio notebook) tanto para o bandido que levou a sua máquina quanto o que vai recebê-la (sim, porque quem compra ou recepta notebooks roubados é bandido do mesmo jeito). Não que você tenha milhões na conta e tenha muito dinheiro. Não é esta a questão. Você pode ser um pé rapado como eu, mas certamente não vai conseguir dormir direito sabendo que coisas íntimas como fotos, documentos, contratos, extratos e outras coisas absolutamente pessoais podem estar nas mãos de bandidos, seja para a prática de golpes ou para simplesmente olhar para suas fotos e pensar: esse é o mané de teve o notebook roubado.

Para evitar isso você pode usar uma senha na BIOS do notebook e argumentar que sem conhecê-la ninguém poderia ligar o seu notebook. Ledo engano. Dar um Clear-CMOS num notebook é algo bastante simples. A senha de usuário do seu sistema operacional (seja ele Windows, Mac, Linux) tampouco poderia proteger os seus arquivos do escrutínio alheio mal intencionado. Tendo em mãos qualquer distro Linux com boot em CD, que pudesse “bypassar” o sistema de autenticação (qualquer que seja) ou mesmo qualquer um destes softwares de recuperação de dados, qualquer bandido relativamente bem instruído (e acredite, eles existem) teria acesso fácil aos seus arquivos.

A única solução real (e atual) para este problema (além da erradicação da violência, claro) é a criptografia. O problema é que normalmente os softwares de criptografia são sacais, tediosos e trabalhosos (mais ou menos como os de backup). Não são todos os usuários que tem saco de, por exemplo, criptografar arquivos, e-mails e fotos toda vez que estes são alterados ou gerados. Na verdade, já seria complicado (em termos de tempo) escolher o que deve e o que não deve ser criptografado dentro do seu notebook. Isso deveria ser feito sem pensar, sem se preocupar.

Criptografar o notebook inteiro pode ser a solução. Buscando exatamente isso, encontrei um software bastante interessante chamado PGP Whole Disk Encryption, da conhecidíssima PGP Corporation, que como o nome diz, criptografa o conteúdo de seu disco rígido por inteiro, tornando impossível acessá-lo inteiramente (ou em partes) sem conhecer a chave de criptografia (o software utiliza o algoritmo AES 256-bit, um dos mais usados por comprovada segurança). Por U$ 143,00 numa licença perpétua, decidi que valia a pena usá-lo, e me surpreendi com a qualidade do mesmo. Entre os pontos fortes está a criptografia em tempo real, sem distinção de arquivos pois o disco inteiro, literalmente, incluindo sistema operacional é criptografado. Há ainda a integração com o seu login no Windows para facilitar o processo de logon (importante: o software só suporta Windows e MacOS por enquanto) e desempenho excelente, sem interferir no uso normal do notebook (imperceptível), entre outros (confira a lista de features).

Se você preza pela sua segurança e privacidade (não se trata de paranóia, mas de mero bom senso e cuidado), não deixe para pensar nisso depois de ter o seu notebook roubado. Fica aí a dica deste excelente software, e que pelo que entrega e faz (e protege), não custa nada caro.

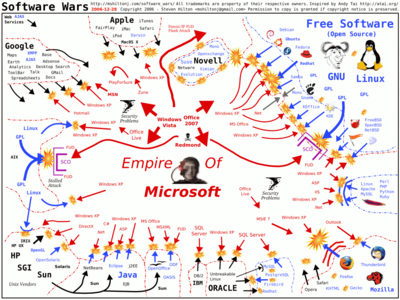

Software Wars

Publicado; 14/01/2007 Arquivado em: Tecnologia Comentários desativados em Software WarsAlguns de vocês já devem conhecer, outros não (dos quais me incluo). O gráfico abaixo (clique para aumentar) é uma divertida representação da “guerra” entre as diversas frentes (empresas, consórcios e grupos) contra o domínio da Microsoft na área.

E o mapa do “circo de operações” é constantemente atualizado. Na versão de Janeiro de 2006, por exemplo, a tropa do IE6 estava batendo em retirada e a do MSIE 5.2 tinha se rendido no front. Divirta-se, imprima e cole no seu mural de recados, como qualquer geek/nerd que se preze faria.

Chefia influente

Publicado; 12/01/2007 Arquivado em: Unsorted Comentários desativados em Chefia influenteRoberto Smeraldi, diretor da ONG Amigos da Terra – Amazônia Brasileira (leia-se: meu chefe) foi indicado pela revista IstoÉ como um dos 100 brasileiros mais influentes de 2007

Os 100 brasileiros mais influentes de 2007

Não se trata de puxasaquismo, é sempre bom divulgar trabalho bem feito, especialmente quando você faz parte dele.

Críticas à Web 2.0

Publicado; 10/01/2007 Arquivado em: Tecnologia, Web 2.0 35 ComentáriosATUALIZAÇÃO: o post abaixo foi condensado e transformou-se num artigo no Webinsider. Devido à maior exposição, gerou um número maior de comentários e compartilhamento de idéias sobre o tema. Desta maneira a leitura do artigo é uma boa pedida para quem deseja ir direto ao ponto e conhecer um maior número de opiniões (favoráveis ou contrárias à crítica).

Artigo “Web 2.0 é uma revolução? Então me deixem criticar“

____

Mais uma vez me vejo as voltas discutindo a tal Web 2.0 na Wikipedia. Desta vez fiz questão de pontuar algumas críticas no referido artigo, especialmente depois que um “especialista” em Web 2.0 (Web 2.0 é um lance novo, “revolucionário”, mas, veja só, tem “especialistas” de monte, atrás de cada moita) apareceu por lá e resolveu alterar substancialmente o artigo, de forma a retratar a tal Web 2.0 como sendo algo realmente novo, revolucionário, quase de outro mundo.

Aparentemente críticos da Web 2.0 não existem (ou são bem poucos) no Brasil. Uma busca no Google retorna pouquíssimas opiniões (sejam de posts, artigos ou mesmo comentários em fórums e listas de discussão) contrárias ao termo e a idéia. Exceção ao já conhecido (e referenciado) post de Henrique C. Pereira no Revolução Etc, que já levantava a lebre há um ano. As críticas são, em sua maioria, importadas. Destaco os artigos de John Dvorak, crítico já conhecido (um dos primeiros) do termo (aliás ele é crítico de qualquer coisa, mas essa é outra história). Por esta razão, tenho me empenhado a dar pequenas contribuições para a crítica, e quem sabe fazer com que outros profissionais adotem uma postura mais crítica e se desvencilhem da tradicional babação-de-ovo e comportamento maria-vai-com-as-outras que acomete defensores apaixonados da Web 2.0 tal como ela é descrita e propagandeada por aqui.

Tenho arrepios ao ler reportagens e textos que tentam explicar o que é a Web 2.0, onde podemos ver declarações como: “A Web 2.0 nasce para reinar” ou “Web 2.0, o futuro da Internet” ou ainda “Web 2.0, uma forma de ficar milionário” e as variações religiosa-ameaçadoras “A Web 2.0 já chegou! Você e a sua empresa não podem ficar de fora!” ou “Esqueça tudo o que você sabe de Internet, chegou a Web 2.0” (esta última, pérola encontrada na revista INFO), entre tantas outras declarações “vibronas” para o termo. E olha que eu não estou incluindo as declarações mais apaixonadas que costumeiramente se vê em qualquer revista de renome e/ou em 10 entre 9 blogs e sites de “especialistas”. A coisa beira a histeria e me lembra muito (ainda que em menor escala) a histeria que acompanhou o boom da Internet no final dos anos 90. Naquele tempo, reportagens de capa, “especialistas” e gurus de toda sorte estavam dedicados a falar e inflar sem culpa a mais nova maravilha do mundo moderno: a Internet. Tinha-se a impressão de que a Internet era capaz de mudar (e melhorar) o mundo radicalmente, quebrar paradigmas (mesmo os mais duros), mudar a vida de todos, curar o câncer, erradicar a miséria e a ganância humana, trazer a paz mundial, entre outros milagres e realizações extraordinárias dignas de Chuck Norris (ok, estou exagerando, mas que os comentários eram exagerados e desproporcionais, eram…). Hoje parece que a Web 2.0 é uma repaginação daquela histeria toda. O trocadilho é inevitável: é a Histeria 2.0 (já patentearam esse termo?).

Para começar, o que exatamente é Web 2.0? Existem mil e uma definições, basta inventar uma (qualquer papagaiada ou buzzword será bem vinda), eu mesmo já “teorizei” sobre o tema. Das explicações que se esforçam para serem sérias, todas trazem um punhado padrão de “regras” para a Web 2.0 (“se você não seguir estas regras, seu site ou sua empresa não será Web 2.0”…). O problema é que ao surgirem novas idéias (ou repaginações) estas são imediatamente jogadas no mesmo saco de “coisas” da Web 2.0, sem qualquer escrutínio, dando a impressão que a tal Web 2.0 é simplesmente um nome que se dá para qualquer coisa que funcione (mesmo que não “funcione”, não dê lucros operacionais – vide YouTube), que seja popular (consiga atrair e reter um bom número de usuários, mesmo que estes sejam formados quase que exclusivamente por adolescentes ávidos por diversão e entretenimento digital de consumo rápido) ou “nova” (mesmo que não seja tão nova assim) na Internet. A coisa é mais ou menos assim: se é pop, então é Web 2.0.

A Web 2.0 não trouxe nada de novo em termos de tecnologia e de idéias, tal como mostrarei mais adiante com alguns exemplos e fatos. A Web 2.0 não é uma mudança tão expressiva ou revolucionária como dizem (e vendem – ah sim, não se iluda, tem muita gente fazendo dinheiro em consultoria com essa nova hype) por aí. Para mim a Web 2.0 poderia ser resumida numa equação bastante simples:

A “VELHA” INTERNET * AUMENTO NO NÚMERO DE USUÁRIOS = WEB 2.0

Note que nesta equação o único elemento “novo” é aumento significativo no número de usuários, especialmente os com acesso a banda larga. Em outras palavras: It’s the user stupid! As idéias e “regras” da Web 2.0 já existiam. O que não existia era um número significativo de usuários e de banda para justificá-las e implementá-las.

É bastante simples entender e verificar isso, mas os “especialistas” da Web 2.0 não vêem as coisas desta maneira. Para eles a Web 2.0 é algo “novo”, “revolucionário”, e que “vai mudar tudo o que está aí”. Estas afirmações implicam na coisificação da Web 2.0, implicam tornar a Web 2.0 um mero produto (acho que exatamente isso que os consultores querem), dar um nome, registro de patente, data de nascimento, versão, regras e pontos bem definidos, etc, sem falar na necessidade de um “criador” (Tim O’Reilly?) e fiéis seguidores. Em minha opinião, os “especialistas” da “Web 2.0” estão para a Internet como os Criacionistas estão para a ciência. Por mais óbvio que seja o fato das coisas simplesmente evoluírem, natural e continuamente, prevalecendo o que funciona em detrimento do que não funciona (tal como Darwin teorizou), os “especialistas” da Web 2.0 insistem que as coisas só existem depois de terem sido criadas, inventadas, nomeadas (de preferência com algum nome descoladinho) e, principalmente, propagandeadas. Alguns gurus mais avançados (aqueles que já atingiram um nível de abstração máximo dessa viagem lisérgica chamada Web 2.0), já estão discutindo seriamente a Web 3.0, cuja equação seria: Web 2.0 + semântica + virtualização de comunidades + qualquer outra idéia ou coisa que se tornar popular até lá (só para garantir que o termo vai “colar” e significar alguma coisa). Agora só faltam dizer que a semântica (e a necessidade dela) e virtualização de comunidades é algo novo na Internet, é uma idéia r-e-v-o-l-u-c-i-o-n-á-r-i-a… O que era motivo de piada parece estar tomando forma.

Os “especialistas” brasileiros aparentemente estão entre os primeiros a abraçar a causa da Web 2.0 (e vão abraçar a Web 3.0, 4.0…) e defendê-la como a nova quintessência da grande rede. Brasileiros são normalmente apaixonados pelo que fazem e acreditam (dizem até que Deus é brasileiro), e é notável esse comportamento entre os profissionais de Internet e a mídia “especializada” no que diz respeito à Web 2.0. Olhando-os de cima, tem-se a nítida impressão de que o caldeirão de crenças, promessas e de gurus (sempre eles) está fervilhando de novo, como há tempos não estava (talvez porque os gurus e especialistas de Web 2.0 de hoje fossem apenas meninos jogando video-game quando a histeria 1.0 terminou, quando a bolha explodiu). Isso é sempre muito bom ($), mas não deveria vir desacompanhado da análise crítica, que aparentemente poucos estão fazendo no caso da Web 2.0.

Pensando bem, não foi sempre assim? É verdade Alex… Por isso, que venha logo a Web 3.0 oras! Metodologias falaciosas, consultorias inúteis, gurus, livros e editores sedentos por pautas “novas” agradecem. Apertem os cintos!

Abaixo reproduzo alguns dos meus argumentos e fatos contrários à idéia de pioneirismo ou de ineditismo das “regras” da Web 2.0 de forma bastante direta. Este texto, com algumas poucas mudanças é o mesmo atualmente disponível na Wikipedia portuguesa (onde colaboro e escrevo para que o artigo não vire uma peça publicitária em favor da Web 2.0). Os argumentos e fatos abaixo servem como partida (apesar de seco e demasiadamente direto, “enciclopédico”) para começar a perceber que na verdade a Web 2.0 não tem nada de novo, que a Web 2.0 não é uma “mudança” (quando muito é uma evolução – que diga-se, é algo bem diferente de mudança). Referências e citações foram retiradas aqui, sendo que as mesmas existem no artigo atual (que vale a pena conhecer). Espero que apreciem.

Sobre conteúdo colaborativo e/ou participativo e inteligência coletiva

Os blogs e a própria Wikipedia são frequentemente mencionados como ícones da Web 2.0. Entretanto interfaces colaborativas, participativas ou capazes de gerar uma suposta “inteligência coletiva” sempre existiram desde que a Internet dava seus primeiros passos (no berço das universidades). Listas e fóruns de discussão – até mesmo a Usenet – são exemplos antigos de colaboração e participação. Vale lembrar que um bom exemplo de real inteligência coletiva (desta vez sem aspas), é aquela gerada por pesquisas sérias e por cientistas que se submetem ao processo de peer-reviewing. Esta inteligência está disponível nas velhas e jurássicas listas de discussão, e provavelmente não vai sair de lá tão cedo. O que se vê hoje na tal Web 2.0 não é inteligência. Inteligência é sinônimo de qualidade, não de quantidade. Os exemplos de “inteligência coletiva” da Web 2.0 são baseados em quantidade (com raras exceções). Sites como Digg.com geram “inteligência” pelo maior ou menor número de “diggs”/cliques num link. Isso é inteligência? O que se gera aí é simplesmente volume, não inteligência. Volume por volume, prefiro as velhas enquetes da Web 1.0… (são burras e imprecisas, mas ao menos assumem que o são). Outros vêem inteligência na enxurrada de tags e nas inúmeras classificações (folksonomia) que mais confundem do que ajudam em sites como o YouTube (tente achar uma informação de forma rápida por lá). Há os que ainda defendem que a inteligência da Web 2.0 está no sistema de rankeamento de links do Google. Quase lá! Outros usam o exemplo do modelo de desenvolvimento de software livre. Opa! Mas espere aí!… há quanto tempo o GoogleRank existe mesmo? 1998? E o desenvolvimento de software livre? Além de serem bem mais antigos, os processos tradicionais do desenvolvimento de software livre são parecidos ao processo peer-review da ciência – que é meritocrático em sua essência – e não podem ser comparadaos o popular oba-oba da Web 2.0. De novo a questão da “novidade” que não é bem uma novidade, e apropriação indébita de idéias antigas e maduras para validar uma falácia pop… Por esta razão, a imensa maioria dos exemplos de “inteligência coletiva” da Web 2.0 são imaturos, incompletos e falhos, passíveis inclusive (e efetivamente o são hoje em dia) de fraudes e problemas justamente por serem inteligências meramente quantitativas (google poisoning que o diga!), muito pouco qualitativas. No editorial de 30/12/06 do Diário de Notícias (português) podemos ler: “a tão exaltada Web 2.0 é, de um ponto de vista meramente quantitativo, um amontoado de lixo.” Eu concordo plenamente. Para poder falar em “inteligência coletiva”, a Web 2.0 precisa ainda comer muito arroz e feijão, pois qualquer coisa que se aproxime de “democracia” não é sinônimo de inteligência, vide nossos políticos.

Se você se interessa por inteligência coletiva na Internet (se ela é ou não é inteligente), sugiro a leitura do excelente artigo de Jaron Lanier, cujo título é bastante apropriado: DIGITAL MAOISM: The Hazards of the New Online Collectivism.

Ainda em 1995 o GeoCities (atualmente pertencente ao Yahoo!) oferecia espaço e ferramentas para que qualquer usuário relativamente leigo construísse seu website e publicasse suas idéias na Internet. A loja virtual Amazon desde o seu lançamento (em 1995) permite que seus clientes e visitantes postem comentários e informações diversas sobre livros que são vendidos na loja. A Amazon também já sugeria produtos correlatos (“pessoas que compram este CD também compram…”) como forma de monetizar ainda mais a operação. Em 1998 o Yahoo! lançava o MyYahoo!, permitindo que a página de entrada do site fosse customizada e personalizada (com notícias, cores e afins) individualmente.

Em suma: Conteúdo participativo e/ou colaborativo e as várias tentativas de inteligência coletiva não seriam idéias novas e revolucionárias, surgidas na Web 2.0. Ao contrário, seriam pilares bem antigos da Internet, permitindo que virtualmente qualquer indivíduo ou empresa, publique, opinie e compartilhe informações na rede.

Sobre a Internet como plataforma

Ainda na metade da década de 90 a Sun Microsystems lançou e patenteou o slogan “The Network is the Computer”, demonstrando sua intenção e posicionamento comercial em fazer da Internet “a” plataforma para todo e qualquer sistema computacional existente (o slogan veio reforçar as promessas de interoperabilidade, portabilidade da linguagem multiplataforma Java – “Write once, run anywhere” – parodiado por alguns como sendo na realidade “Write once, crash anywhere”). Ainda em finais da década de 90, começaram a surgir alguns padrões de interação entre aplicativos Internet, para que as então chamadas transações B2B pudessem ser realizadas de forma padronizada. O termo Webservices e o protocolo SOAP ganharam força e se popularizaram, sendo padronizados mais tarde pelo do W3C em 2001. Em 2002, Amazon, Google e vários players importantes desenvolveram e publicaram APIs para que desenvolvedores de todo mundo pudessem integrar seus serviços com o destas empresas. Redes P2P surgiram e fizeram sucesso muito antes de se ouvir falar em Web 2.0. Cita-se o popular Napster, ícone desta “revolução” ocorrida em 1998. Exemplos são inúmeros (passando por sistemas de controle pessoal – ex. site Elefante.com.br), financeiros (câmbio), previsão do tempo, etc.

Sobre tecnologias novas

Apesar de o termo AJAX ter sido usado pela primeira vez em 2005, as tecnologias que englobam o termo tiveram início ainda no final da década de 90, nos navegadores de geração “4” (Internet Explorer 4.0 e Netscape Navigator 4.0), que introduziram suporte à técnicas de remote-scripting. Com o lançamento da versão 5.0 do Internet Explorer em 2000, e a estagnação do Netscape Navigator (que mais tarde teve seu código fonte aberto gerando o excelente Firefox), a Microsoft inaugurou uma forma mais elegante de remote-scripting com o XMLHttpRequest. Daí até os dias atuais o conceito só evoluiu, ganhando força e notoriedade devido ao aumento no número de usuários da rede. Linguagens e frameworks de desenvolvimento rápido para web (RAD) já existiam antes da Web 2.0. Pode-se citar a linguagem ColdFusion da Allaire (1995) e o Fusebox (1998). A sindicância de conteúdo (famosa hoje pelo RSS), já chamada no passado de “conteúdo push” já era conhecida de usuários do Internet Explorer 4.0 e o seu serviço ActiveChannels. Agências de notícias como a Reuters já utilizavam sistemas de intercâmbio de conteúdo e notícias entre agências e consumidores de notícias muito antes do surgimento da Web 2.0, sistemas estes que inclusive foram os precursores dos padrões atuais. O próprio XML data de 1997. A portabilidade de sistemas para dispositivos móveis (a tão aclamada “convergência”), é um discurso antigo, que antecede em muito a Web 2.0, e que sempre esteve em constante evolução, cujo passo inicial remonta os primeiros dispositivos móveis, sejam eles celulares ou PDAs.

Sobre mudanças em marketing

Os críticos argumentam que não houve uma mudança significativa no marketing praticado pela Internet. Segundo eles, o dinheiro (oriundo de ações de marketing) continua sendo gerado da mesma maneira: via publicidade e serviços. Como exemplo: a maior parte dos lucros do Google vêm (e sempre vieram) de anúncios vinculados às suas buscas e sites que utilizam seus serviços. O Yahoo! por exemplo tem um modelo misto: publicidade e serviços. O Yahoo! Small Bussiness não é novo, já existia (porém não com esse nome) desde a época do GeoCities, quando você podia pagar um valor para ter mais espaço, vincular um domínio ao seu site, etc. Desde que eu me dou por gente, a Web sempre foi serviços. Conceitos como o de marketing viral são bastante antigos, sendo que seu vínculo com a Internet alvo de um livro (Idea Virus) de Seth Godin ainda em 2001. Empresas de publicidade na Web (ex. DoubleClick) já empregavam o pagamento por retorno antes do advento do termo Web 2.0. O próprio Google AdSense e AdWords não são serviços novos, derivam de empresas que já atuavam na Internet antes do Google (Applied Semantics – adquirida pelo Google e Goto/Overture, adquirida pelo Yahoo!).

As críticas e fatos não param por aí. Engrosse a lista se desejar. Na Wikipedia qualquer um pode editar. Lembre-se apenas de saber como fazer isso de forma parcial e respeitosa. Leia as guias de ajuda antes de começar a editar por lá, vai te poupar um bocado de dor de cabeça com os xerifes e “especialistas” que lá habitam.

Mas ainda não terminou. E o que os “especialistas” da Web 2.0 vão dizer sobre as críticas? Bem, eles vão dizer que não é bem assim, não é bem assado, que a “Web 2.0” é outra coisa, que a gente não entendeu nada porque é difícil entender, isso e aquilo… (prepare os ouvidos). O próprio guru-mór do termo, Tim O’Reilly já começou a “adaptar” (para não dizer mudar sutil e convenientemente) aquilo que ele já tinha papagaiado e dado como certo há cerca de um ano. A estratégia do figura é ir definindo a coisa enquanto ela está acontecendo e/ou puxando a atenção para as coisas que fazem mais sentido, descartando as besteiras ditas no passado. É o beta perpétuo de idéias, que também perpetua a sua exposição na mídia (o que é bom para ele e suas empresas). O’Reilly é acima de tudo um cara esperto. Que se dane o termo (ele malandramente já nem faz tanta questão de defendê-lo), o que importa são as idéias, o que importa são as pessoas… Lindo, mas tão vago e subjetivo como dizer que a “individualidade é algo muito pessoal”… Aliás, um parêntesis imporante aqui: por falar em vastidão, não deixe de conhecer o fabuloso gerador de lero-lero, perfeito para quando você quiser falar bonito sem falar nada. Se você é um “especialista” em Web 2.0 certamente vai adorar.

Mas não se engane: é só virar as costas que os especialistas voltam ao mesmo discurso e a descontrolada mania de botar nome em tudo o que vêem, over-and-over-and-over.

Continue fazendo seu website, suas aplicações, seus mashups, seja lá o que for sem se preocupar com a meme, a hype e todo o alvoroço (incluindo consultores e gurus paraquedistas) da Web 2.0. Continue fazendo-os com qualidade e com inteligência, melhorando-os sempre que possível. As regras do bom senso nunca tiveram uma versão 2.0. Pense nisso.

Leia também a versão 1.0 deste post.

Sobre o autor: Alex Hubner é gerente de tecnologia da ONG Amigos da Terra – Amazônia Brasileira e palpiteiro nas horas vagas.

ColdFusion 7 security patch para IIS

Publicado; 10/01/2007 Arquivado em: Sem categoria Comentários desativados em ColdFusion 7 security patch para IISSaiu um security patch importante para o CF7 hoje. Trata-se de uma atualização do conector web para IIS. Não deixe de ler e aplicar:

Patch available for ColdFusion MX 7 information disclosure issue

IBM OmniFind Yahoo! edition

Publicado; 14/12/2006 Arquivado em: Tecnologia Comentários desativados em IBM OmniFind Yahoo! editionA IBM já fazia o OmniFind há algum tempo, porém lançou-o em versão gratuíta em parceria com o Yahoo! O OmniFind é um software “enterprise” de indexação e busca de documentos (locais ou remotos), incluindo “documentos web” (leia-se: websites) bastante poderoso. Estou baixando para testar. Se você tiver curiosidade, sugiro fazer o mesmo: http://omnifind.ibm.yahoo.net

Almoço com Luciano Ayres

Publicado; 13/12/2006 Arquivado em: Unsorted 2 ComentáriosAcabo de voltar de um animado almoço com Douglas Camargo, Terracini e Luciano Ayres, que está em São Paulo esta semana. Entre uma garfada e outra, Luciano nos contou um pouco sobre o desenvolvimento de aplicações para dispositivos móveis usando Flash-Lite. Mas a conversa não ficou por aí. Falamos de Adobe, de Microsoft e de tecnologia como um todo. Valeu bastante a pena. Espero poder repetir a dose com outros profissionais tão gabaritados como o Luciano.

Da esquerda para a direita: Fabio Terracini (fundo), Alex Hubner (vermelho), Douglas Camargo (fundo) e Luciano Ayres. Destaque especial para o garçom que tirou umas cinco fotos antes desta (todas cortando a cabeça ou o corpo de alguém).

Scorpio no Labs

Publicado; 07/12/2006 Arquivado em: ColdFusion Comentários desativados em Scorpio no LabsTal como suspeitei, o Scorpio, codinome para a próxima versão do ColdFusion, já aparece no Adobe Labs. O download ainda não está disponível, mas estará assim que o primeiro beta sair (atualmente está em alpha2), provavelmente no início do ano que vêm. Por enquanto dá para ler algumas coisas interessantes e baixar alguns wallpapers feiosos (imho). Confira:

http://labs.adobe.com/wiki/index.php/Scorpio

Adicionalmente existe um álbum de screenshots de algumas telas de instalação e CFadministrator (incluindo o server monitor) do Scorpio (alpha2) disponível aqui.

[via Rob Gonda]

Virtua queima roteadores e placas de rede

Publicado; 02/12/2006 Arquivado em: Sem categoria 51 ComentáriosObviamente a NET nega, mas o Virtua queima placas de rede, roteadores e qualquer equipamento ligado a ele com uma freqüência impressionante. Já fui vítima da rede Virtua por mais de uma vez. A última foi semana passada, aqui em casa. Durante uma daquelas chuvas torrenciais (acho que foi a de segunda-feira), o meu roteador queimou. Eu tinha um Hotbrick 401 soho, excelente, que infelizmente foi para o espaço (você consegue sentir o cheiro de queimado pelas aletas de ventilação), por culpa da rede Virtua, que é bem perigosa.

UPDATE 01/05/2007: semana retrasada queimou o roteador aqui do escritório, pela quarta vez em 3 anos. Lá se foi um Hotbrick LB2 que custou dois mil reais. Eu realmente já não sei o que fazer. Ele estava ligado com um protetor de rede RJ-45, mas não fez a menor diferença.

Em comum a todas as ocasiões o que queima é a porta WAN, que está diretamente ligada ao cabe-modem. Todas as demais portas LAN e o próprio roteador (sistema de administração web, etc) continua funcionando sem problemas. Em computadores ligados ao Virtura, a placa de rede que está ligada ao cable-modem é a que sempre queima, as outras ficam intactas. Você deve estar se perguntando: mas e o cable-modem, não deveria queimar? Não. Estranhamente (em todas as vezes) ele não queimou – isso deve ter uma explicação técnica – explicação essa aliás que é a desculpa de alguns atendentes da NET quando questionados sobre a queima da placa/roteador: “se o cable-modem não queimou, como pode ter queimado a placa de rede?” Eu não faço a menor idéia do porquê. A única coisa que eu sei, por experiência própria é que é muita coincidência que sempre a porta WAN (ou a placa diretamente ligada ao cable) seja fritada. Eu vivi isso 4 5 vezes! Não é coincidência ou azar, é fato.

E antes que pensem e digam: pode ser um problema elétrico na sua residência e no seu escritório. Não é. Explico: estou morando numa casa que foi totalmente reformada, incluindo a parte elétrica. O serviço de elétrica foi feito por um profissional gabaritado e eu dei especial atenção ao sistema de aterramento, absolutamente aderente às normas ABNT (incluindo medições de resistência e afins) – cheguei até usar TerraGel, um produto bem específico (e caro) que torna a terra ao redor das hastes (são três, em triângulo) eletricamente “adequada” para o terra – em resumo: fiz questão de dar máxima importância a isso. Além disso, todos os equipamentos de rede estão ligados em nobreaks. Nenhum outro equipamento queimou, inclusive outros roteadores ligados à rede Speedy (Telefonica), que também temos no escritório, e que nunca queimou. A única coisa que quima é a porta WAN roteador, que está ligado diretamente ao cable-modem do Vírtua. É de se estranhar não? Como eu já disse, o roteador funciona, porém a porta WAN está morta, queimada (sequer acende as luzes indicativas de link e de atividade). Isso acontece no caso do roteador. Se você ligar o cable-modem diretamente no PC ou servidor, vai ser a placa de rede certamente queimará, o que de fato já aconteceu no escritório uma vez quando colocamos um roteador baseado em PC.

Meu Hotbrick se foi e para substituí-lo (minha esposa trabalha de casa e estava quase maluca sem Internet) eu comprei um roteador mequetrefe, bem basicão (um Dlink DI-604), desses que vende no Carrefour. Sei que isso vai acontecer de novo e eu não quero perder dinheiro num roteador caro como o Hotbrick. Entretanto, como medida paliativa, coloquei um protetor para linha de dados MPH-RJ45 da MTM (veja aqui), mas tenho dúvidas de que ele funciona e pode salvar o roteador de ser fritado pelo Virtua (UPDATE 01/05/2007: não funcionou mesmo). Não custa tentar, ainda mais com o período de chuvas (e o aquecimento global tornando-o imprevisível) se aproximando.

Agora o fato vivido (com reflexos financeiros) e que eu não posso negar (baseado em experiências próprias) é: o Vírtua da NET queima placas de rede e roteadores. Fique esperto.